Raspberry Pi Ltd.は9月25日にRaspberry Pi 500+をリリースしました。価格は200ドルです。

https://www.raspberrypi.com/news/the-ultimate-all-in-one-pc-raspberry-pi-500-plus-on-sale-now-at-200

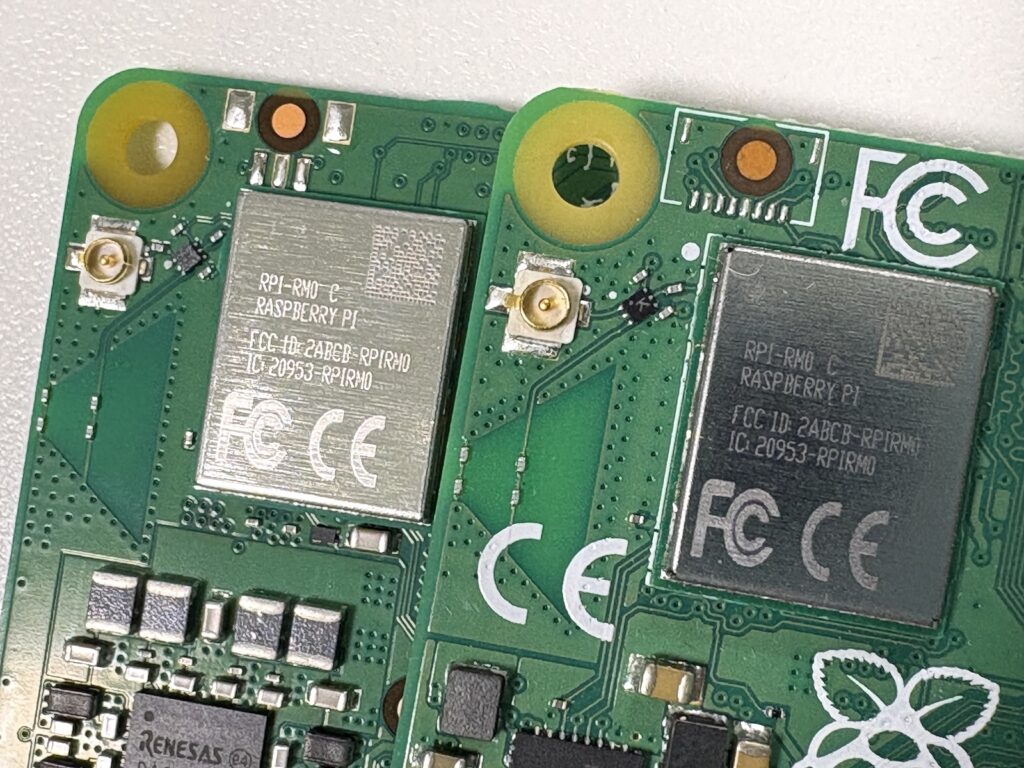

Raspberry Pi 500+は、先に発売されたRaspberry Pi 500のキーボード部分を、メカニカルキーボードに変更したモデルです。メカニカルキースイッチにはGateron KS-33ブルースイッチをRAL 7001シルバーグレーステムにカスタムしたクリッキーキースイッチが採用されています。メインのシステム基板はRaspberry Pi 500と共通で、ポートも同様の配置ながら、RAMは8GBから16GBに変更されています。また、256GB M.2 NVMe SSDが内蔵されている(交換可能)ため、快適な打ち心地のキーボードを備えた、強力なデスクトップマシンとして使うことができます。

別の記事では、Raspberry Pi Official Magazine 158号から抜粋された、Raspberry Pi 500の開発インタビューが掲載されています。

https://www.raspberrypi.com/news/meet-the-engineers-behind-raspberry-pi-500-plus

日本での販売については、各社より以下の通りアナウンスされています。気になる方はチェックしてみてください(随時追記予定です)。

スイッチサイエンス: https://prtimes.jp/main/html/rd/p/000000217.000064534.html

本体のみが39,600 円、キットが43,560 円(いずれも税込)

KSY: https://raspberry-pi.ksyic.com/main/index/pdp.id/1221/pdp.open/1221

日本語配列版をレビュー!

さて、今回はRaspberry Pi 500+の日本語配列版のサンプルをお預かりしていますので、写真でレビューをしていきます。ちなみに、先述のインタビュー記事で、写真左のChris Martin氏が手にしているのが日本語配列版のようでした(公式マガジンを定期購読しているため、PDF版を入手して拡大したらそのようでした)。

なお、サンプル品のため、製品版とは使用が異なる場合があります。あらかじめご了承ください。

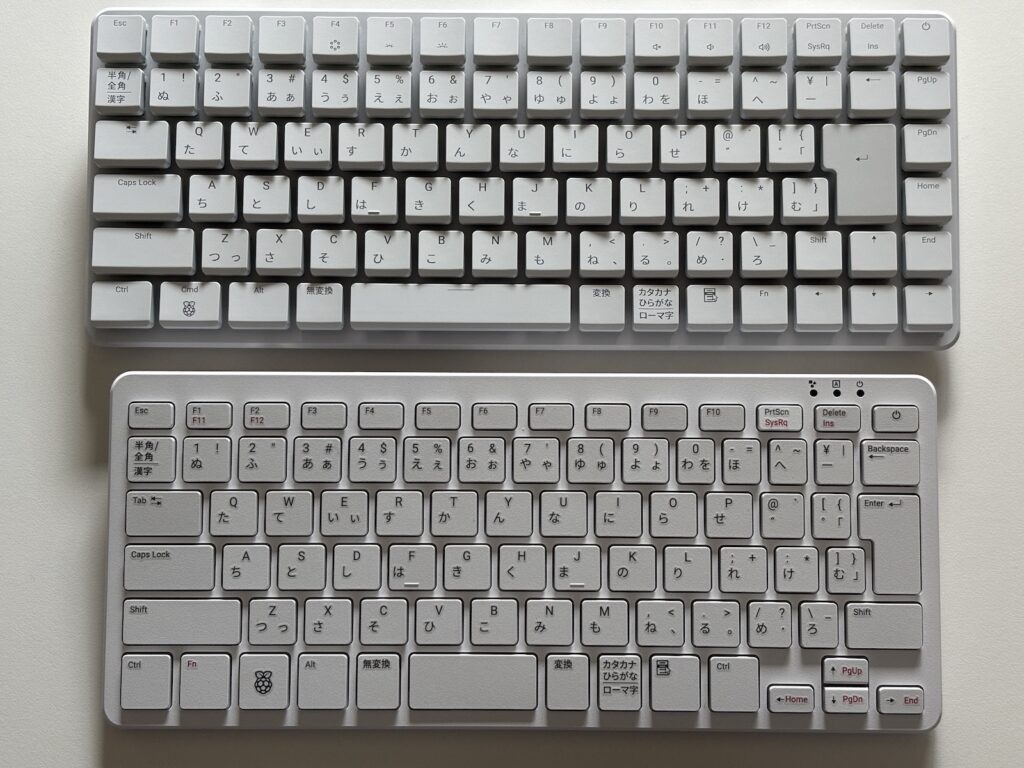

まずは本体表面です。キーボードの印字は大きくて見やすく、配列も自然です。

本体裏面はこちら。下の袋には、キーキャップを外すための道具と、本体ー開くときのヘラが付属していました。

Raspberry Pi 500と比較すると、500よりも500+のほうが一回り大きくなるようです。

IOまわりは、冒頭でもふれた通り、基板が共通のため、全く同じです。強いて言えば、500にはあったセキュリティスロットが省略されています。

側面から見てみると、Raspberry Pi 500+は結構高さが増えています。キースイッチの違いによるものだと思いますが、こうしてみるとインパクトがありますね。

キースイッチについても冒頭で触れましたが、Gateronのクリッキーキースイッチが採用されています。ステムの色カスタムについては気づかなかったため、存在しないキースイッチのようだな……?と思ってはいましたが、納得の理由でした。ロープロファイルキースイッチながら、

キーキャップはCherry MX互換であるため、キーキャップを自由に入れ替えて、好みのキーボードデザインに変えることが可能です。全部を変えてもいいですし、一部だけアルチザンキーキャップに変えておしゃれにして見ても良いかもしれませんね。

さっそく分解

動かしてしまえば後はいつものラズパイですので、先に一旦分解して中身を見てしまいましょう。分解については、公式が手順をアナウンスをしているため、安心して実行できます。その理由は、M.2 SSDの交換の時に必要になるためです。

https://www.raspberrypi.com/documentation/computers/keyboard-computers.html#replace-m2

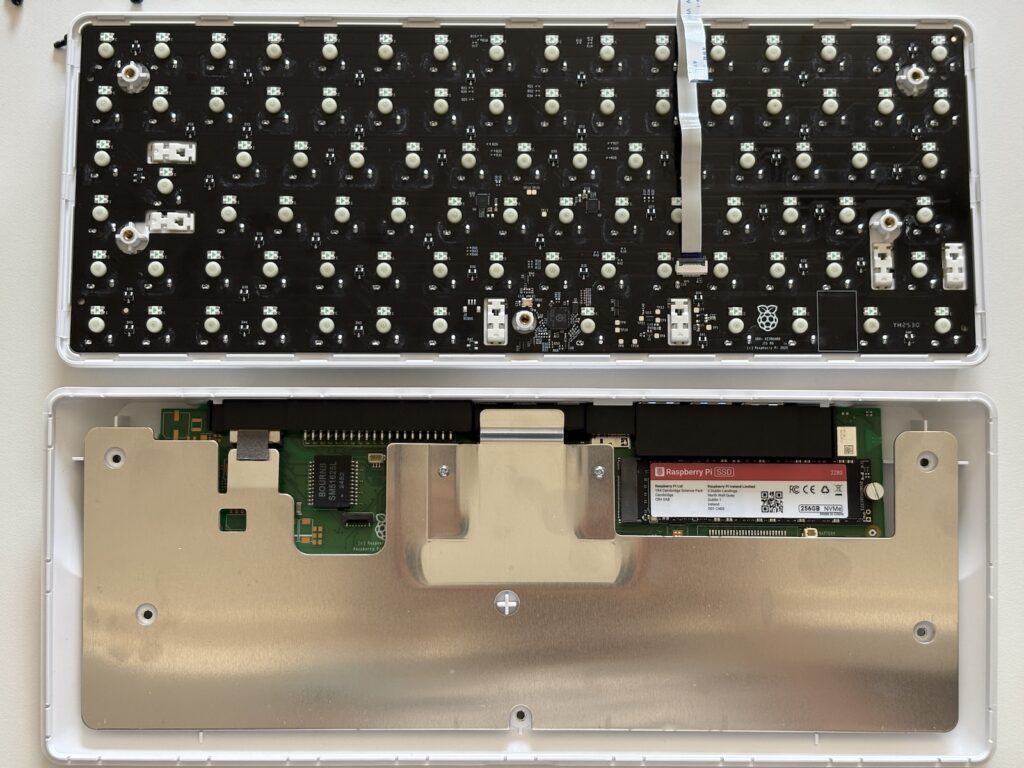

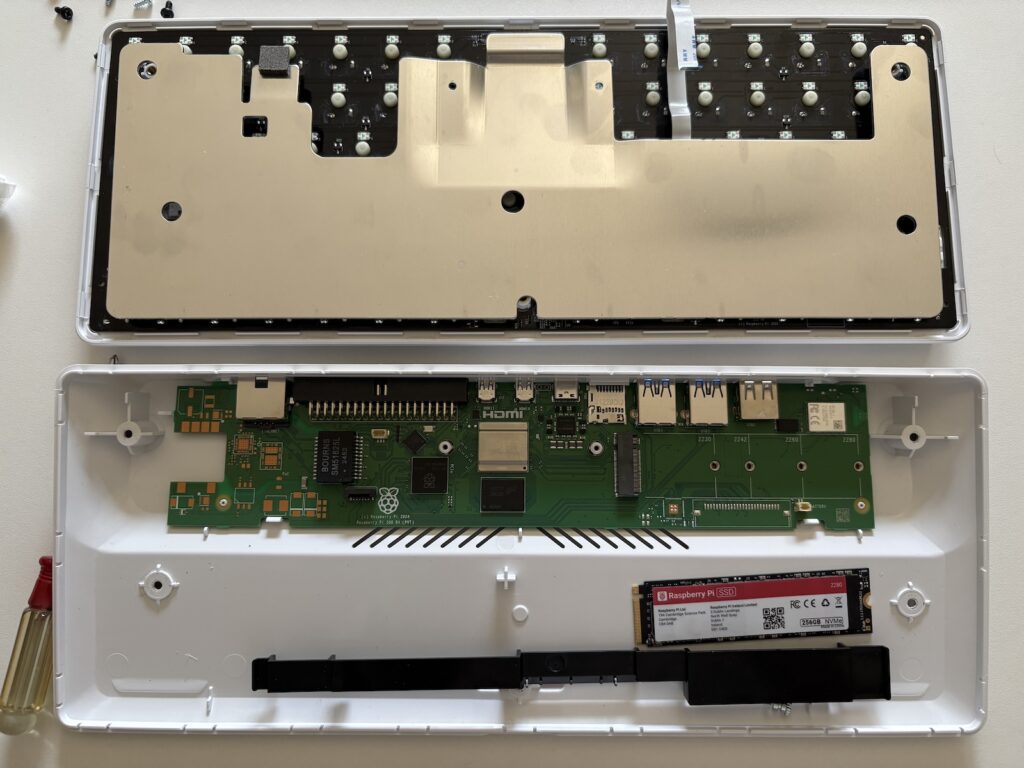

分解は、背面の5つのネジを外して、スペースバーのあたりからキーボードと本体を分離するように開きます。この時、開きすぎてキーボードのリボンケーブルを破損しないように注意してください。外すと以下のようになりました。

残念ながら、キースイッチはスワップ非対応で、直接はんだ付けされていました。また、キーボードのコントローラーはRP2040が採用されていますね。

本体の方は、というと、ほとんどが銀色のプレートで覆われています。これがRaspberry Pi 500+のSoCの熱を逃がす放熱板として機能していて、中央上部の凹みの部分にSoCがくっついています。プレートが覆われていない部分に、今回の目玉の一つである、M.2 NVMe SSDスロットがあります。SSD交換だけであれば、プレートを外さずに交換ができましたが、手回しネジを手で回すにはプレートがいささか邪魔でしたので、マイナスドライバーを使うのが良さそうです。

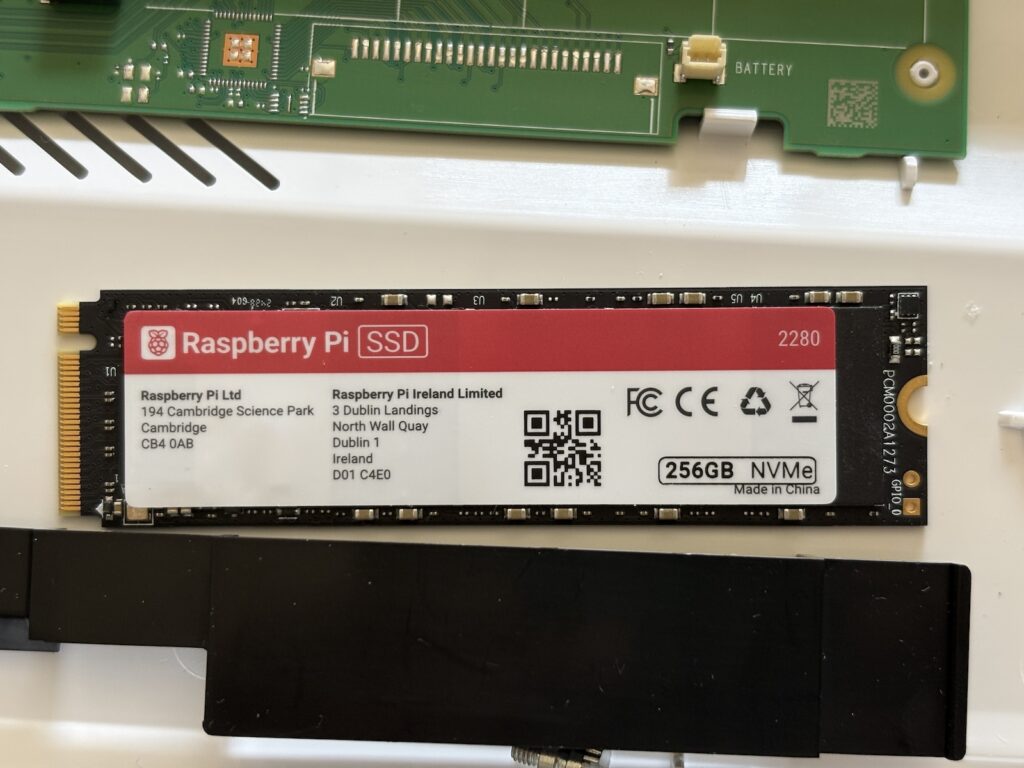

こちらはSSDの拡大。現在Raspberry Pi が公式に販売しているSSDは、256GB、512GB、1TBのいずれも2230サイズですので、Raspberry Pi 500+から出てきたこの2280サイズのSSDは”新種”ということになりそうです(が、別の人のレビューを見ると2230サイズらしく、サンプルだからでしょうかね……?)。もっと大容量なものを搭載したいときには、自分で交換ができます。

スロットのほうが2280サイズにしか対応していないのかと言うとそうでもなく、2230、2242、2260、2280の4サイズに対応しています。場合によっては公式の2230サイズのSSDを購入して搭載するのでも良さそうですね。

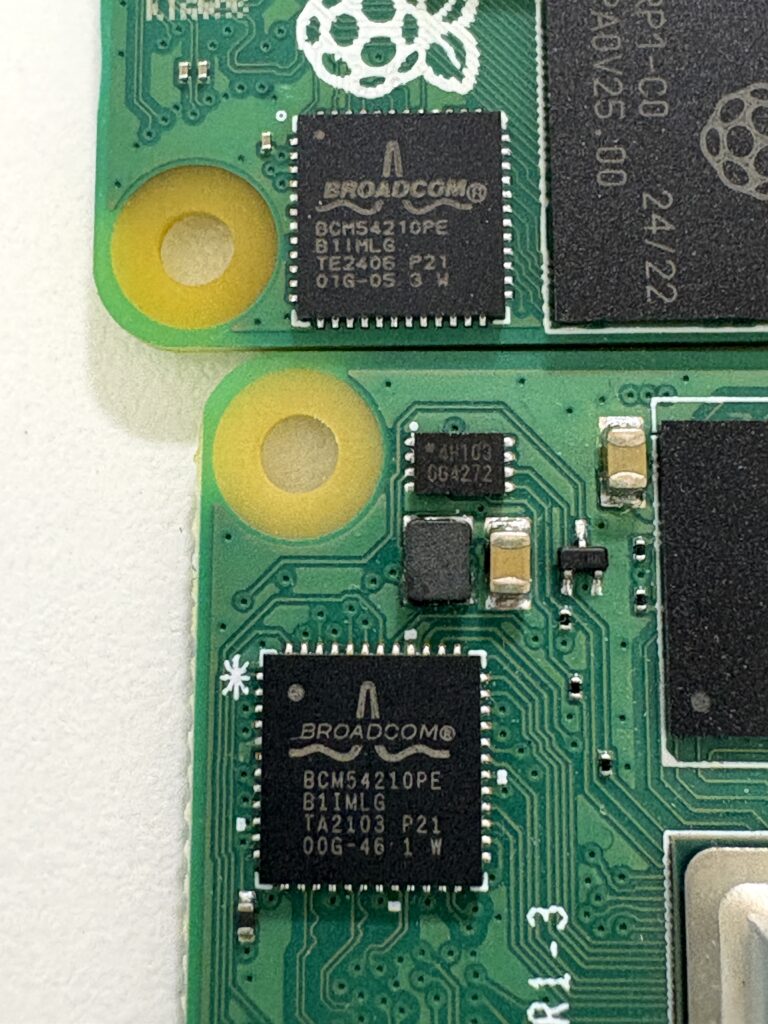

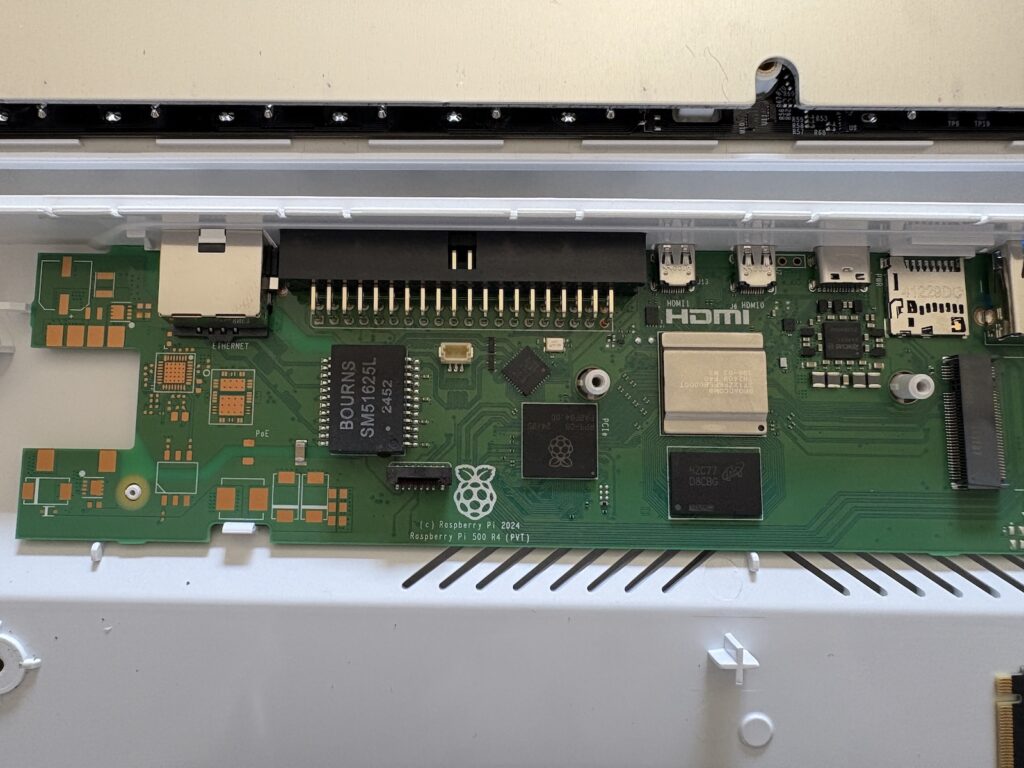

放熱プレートも外してみましょう。先述の通り、プレートの凹みの部分にSoCがあります。

左側にまだ未実装のパターンが見えますね。PoEの文字がある通り、実装しようと思えばPoEも搭載できる?のかもしれませんが、Raspberry Pi 500のPoE対応版どころか、Raspberry Pi 5公式のPoE+ HAT+も未発売のままです。今後されにモデルが増えるのかも気になるところです。

動かしてみる

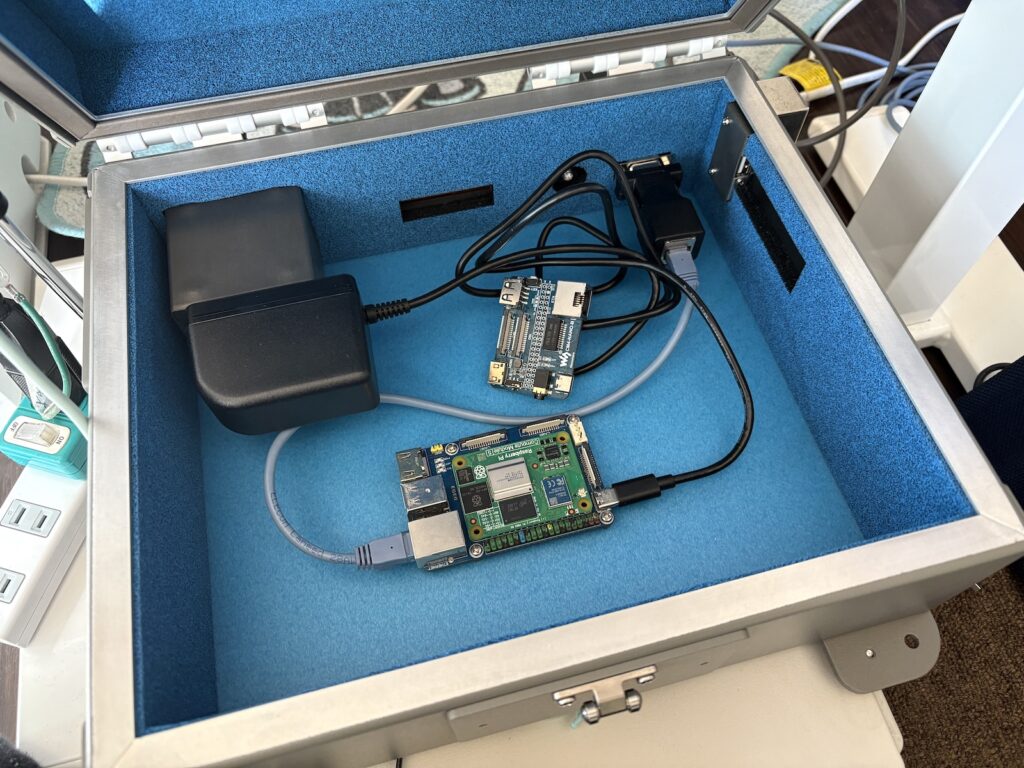

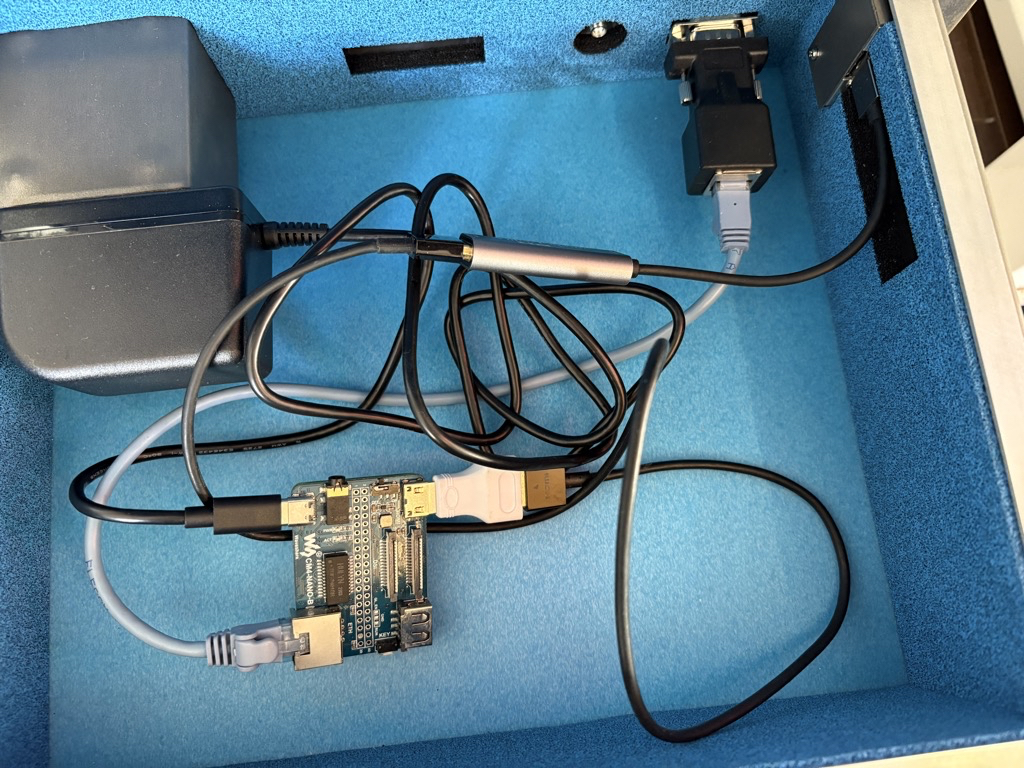

今回は「技適未取得機器を用いた実験等の特例制度」の開設届出を提出して、実験をおこないます。そして、ここからの執筆は実際にRaspberry Pi 500+から入力していきます。

まずは電源投入から。電源ケーブルを接続するとすぐに起動が始まるため、動画の様子は一度電源を切ったところから、電源ボタンを押して起動をしています。電源が入ると、虹色に激しく?光りますが、基本的にはここだけで、右上の電源ボタンが常に光るのと、CapsLockをオンにするとCapsLockキーが光る程度です。

キーボードの打鍵音はこんな感じです。←という文字を入力している動画です。かな入力なので打件数が少ないですが。押し心地は軽快で、クリッキーキースイッチらしいカチカチ音が特徴的です。

これはおそらく個人的な問題なのですが、普段Macの配列に慣れているせいか、あるいはEnterキーの右側にHome、End、PgUp、PgDnキーの縦一列があるせいか、その両方なのかは不明ですが、気がつくと指の置き場所がズレて、結構タイプミスをしてしまいがちでして、じつは慣れません……。BackSpaceと長音の打ち間違いは間違いなく全角半角キーがないMac配列への慣れの影響を感じていますが、他の段でもtypoしているのは個人的には理由がよくわかっていません。Raspberry Pi 500ではこのような感覚にはならなかったので、これは不思議に思っているところです。タッチタイピングをちゃんと習得していない我流配置かな入力をやっていて、当然ホームポジションも無視しているので、こうなっている可能性も高いとは思います。そういう意味では、実機を触って確かめてから購入に進むのが個人的にはおすすめです。

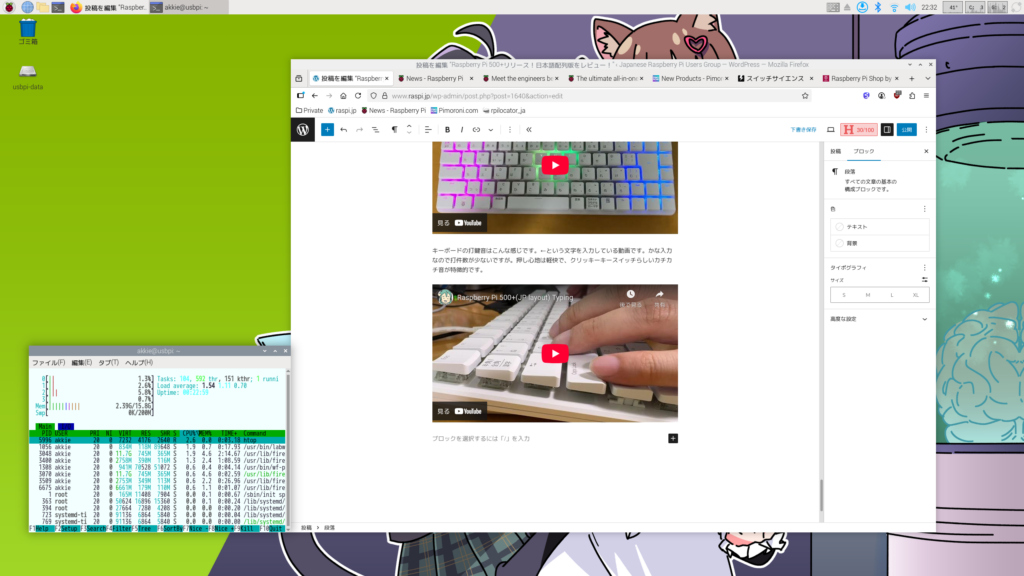

使用中の様子にhtopコマンドを添えてみました。16GBのRAMがあり、ブラウザを起動してタブをいくつか開いてみましたが、使用量は2.37GB程度でした。自宅のサブサーバーにPi 5 16GB RAM版を投入して、Dockerホストやら何やらを載せても使い切れなかったのですが、単純なデスクトップ用途でも使い切るのはもしかして難しいのかもしれません……?

ちなみに画面右上にはSoC温度、CPU・GPUの使用率を並べていますが、これだけタブを並べた直後でも41度というぬるさで動作しています。放熱プレートおそるべし。

つづけてSSDの性能テストです。じつは今触っているテスト環境は都合により自分のUSB SSDから起動しているのですが、NVMe SSD自体にはアクセスできるので、hdparmでリードテストを軽く実行してみましょう。とはいえ、Pi 5にSSDを搭載しているときと結果は変わりなく、PCIe3.0を有効にした環境では800MB/sちかい性能を引き出すことが可能です。

$ sudo hdparm -t /dev/nvme0n1

/dev/nvme0n1:

Timing buffered disk reads: 2456 MB in 3.00 seconds = 818.61 MB/secまとめ

キーボード一体型Raspberry Piシリーズ初となる500+が登場して、メカニカルキーボード・16GB RAM・256GB M.2 NVMe SSDを採用した(そして虹色に光る!)超ハイスペックなデバイスになりました。

お値段はRaspberry Piらしからぬ高級ぶりですが、採用している部品一つ一つを見れば納得の価格ではあります。そもそもメカニカルキーボードって時点でお安くはないですからね……。こだわってみたい!という人は500+を、普通スペックでも問題ない人は500を、という棲み分けは全然可能でしょう。写真の通り、物理サイズなども違いますので、そういった点でも好みに応じた選択ができるでしょう。

改めて、日本での販売開始については、各リセーラーの情報を確認の上、入荷通知設定やSNSのフォローなどを活用すると良いでしょう。